引言

随着大数据时代的到来,实时数据处理和分析变得越来越重要。在众多实时数据处理框架中,Apache Flink凭借其强大的流处理能力和高效的数据处理性能,成为了业界的热门选择。本文将介绍如何使用Flink进行实时计算,并生成统计报表,以满足现代业务对实时数据分析的需求。

什么是Apache Flink

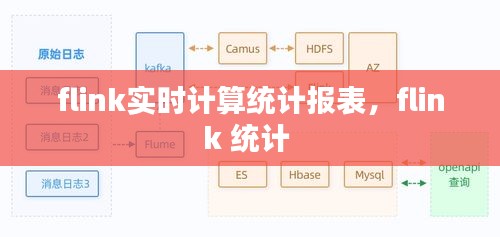

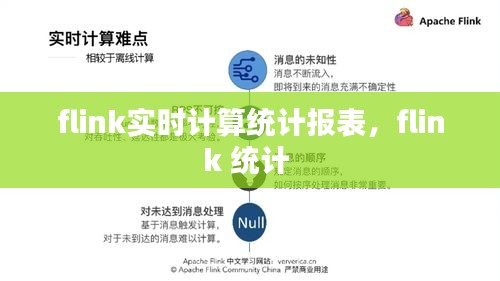

Apache Flink是一个开源的流处理框架,它可以高效地处理有界和无界的数据流。Flink支持多种数据源,包括Kafka、RabbitMQ、Twitter等,并且能够处理复杂的实时计算任务,如窗口操作、状态管理、复杂事件处理等。Flink的流处理能力使其在金融、电信、电商等行业中得到了广泛应用。

实时计算统计报表的需求

在许多业务场景中,实时计算统计报表是必不可少的。例如,电商网站需要实时监控用户购买行为,金融行业需要实时分析市场趋势,这些都需要实时计算和统计报表的支持。实时计算统计报表可以帮助企业快速响应市场变化,做出更准确的决策。

使用Flink进行实时计算统计报表的步骤

以下是使用Flink进行实时计算统计报表的基本步骤:

数据源接入:首先,需要接入实时数据源,如Kafka、RabbitMQ等。Flink提供了丰富的数据源连接器,可以方便地接入各种数据源。

数据转换和清洗:在数据源接入后,需要对数据进行转换和清洗,以确保数据的准确性和一致性。Flink提供了丰富的数据处理API,如map、filter、flatMap等,可以方便地进行数据转换和清洗。

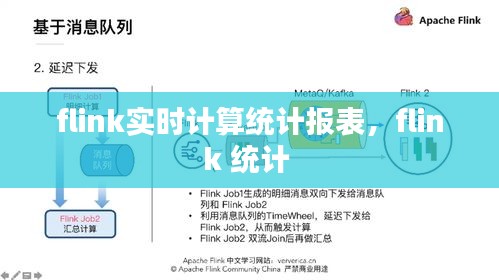

定义统计逻辑:根据业务需求,定义统计逻辑。例如,计算用户购买行为的频率、金额等。Flink支持窗口操作,可以方便地对数据进行时间窗口划分,进行实时统计。

输出结果:将统计结果输出到目标系统,如数据库、HDFS、Kafka等。Flink提供了多种输出连接器,可以方便地将结果输出到不同的系统。

监控和优化:实时监控系统性能,并根据监控结果进行优化。Flink提供了丰富的监控工具,如JMX、Prometheus等,可以帮助开发者实时监控系统状态。

案例分析:电商用户购买行为分析

以下是一个使用Flink进行电商用户购买行为分析的案例:

数据源接入:接入Kafka数据源,获取用户购买行为数据。

数据转换和清洗:对购买行为数据进行清洗,去除无效数据,如重复记录、异常数据等。

定义统计逻辑:计算每个用户的购买频率、平均购买金额等统计指标。

输出结果:将统计结果输出到数据库,以便后续分析和展示。

监控和优化:实时监控系统性能,根据监控结果调整资源分配,确保系统稳定运行。

总结

Apache Flink是一个功能强大的实时数据处理框架,可以满足现代业务对实时计算统计报表的需求。通过接入数据源、数据转换、定义统计逻辑、输出结果和监控优化等步骤,可以轻松地使用Flink构建实时计算统计报表系统。随着大数据技术的不断发展,Flink将在更多领域发挥重要作用。

转载请注明来自大成醉串串企业,本文标题:《flink实时计算统计报表,flink 统计 》

蜀ICP备2020032544号-3

蜀ICP备2020032544号-3